دراسة من Apple: النماذج اللغوية الكبيرة عاجزة عن المحاكمة المنطقية

⬤ حصلت النماذج اللغوية الكبيرة على اهتمام عالمي مع استشارة البعض لها في مختلف نواحي الحياة.

⬤ تؤكد دراسة من Apple واقعاً كرره الخبراء سابقاً: النماذج اللغوية الكبيرة سيئة في التحليل المنطقي.

⬤ بينما أنها مثالية لتوليد نصوص تبدو حقيقية، فنصائح وإجابات هذه النماذج ليست ناتجة عن محاكمة.

دراسة من Apple: النماذج اللغوية الكبيرة عاجزة عن المحاكمة المنطقية

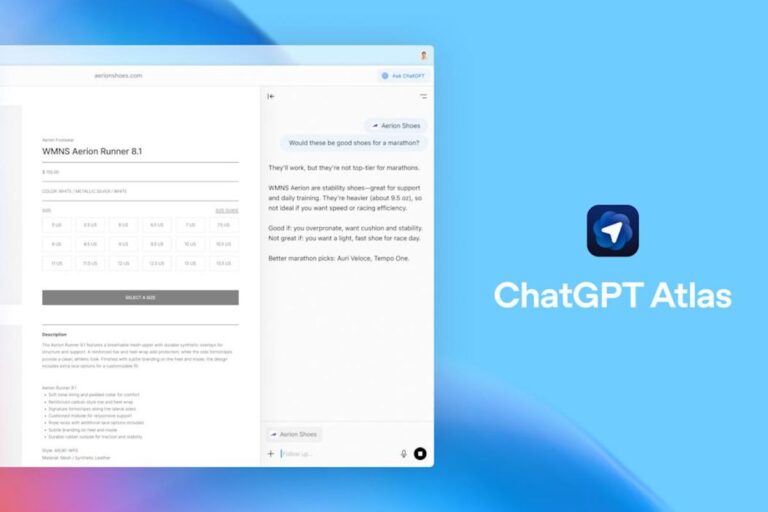

توصلت ورقة بحثية حديثة أعدها علماء في مجال الذكاء الاصطناعي في Apple إلى أن المحركات المستندة إلى النماذج اللغوية الكبيرة، مثل تلك التي من Meta وOpenAI، لا تزال تفتقر لمهارات المنطق الرئيسية.

اقترح الباحثون معيار قياس جديداً لمساعدة الآخرين في قياس القدرات المنطقية للنماذج اللغوية الكبيرة. وكشفت النتائج الأولية لذلك أن مجرد تعديل بسيط في الكلمات المنصوص عليها في المطالبات والأسئلة يمكن أن يقود إلى إجابات مختلفة كلياً، وهو كشف يقوّض موثوقية الأدوات القائمة على تلك النماذج.

في تفصيل الاختبار، حاول العلماء الكشف عن مدى هشاشة الفكر الرياضي المنطقي عبر إضافة معلومات سياقية إلى المطالبات المدروسة لا تؤثر على السير المنطقي الأساسي للعملية وبمقدور الإنسان الطبيعي فهمها. ووجدوا تبايناً بارزاً في الإجابات.

بتوصيف أدق، يبدو وأن انحدار مستوى التعليل المنطقي يتناسب طرداُ مع عدد البنود المدرجة في نص الطلب، لدرجة أن إضافة عبارة واحدة محايدة لطلب رياضي معطى قد تقلل من دقة الإجابة بنحو 65%.

من الأمثلة الفعلية التي تضمنها البحث مسألة رياضية من مستوى طلاب المرحلة الدراسية الابتدائية، وقد أعطيت ليتعامل نموذج الذكاء الاصطناعي معها. وفحواها أن «أحدهم اشترى 44 ثمرة يوم الجمعة، ثم اشترى 58 أخرى يوم السبت. وفي الاحد، اشترى ضعف ما اشتراه يوم الجمعة من الثمار». وطُلب من الروبوت إعطاء مجموع الثمار المشتراة.

أُلحقت بذلك الطلب عبارة غير ذات صلة ولا تؤثر منطقياً على النتيجة أبداً، وهي أن «خمساً من تلك الثمار كانت أصغر قليلاً من المتوسط.» وكانت المفاجئة أن نموذج OpenAI ونموذج Llama3-8b من Meta طرحا تلك الثمار الخمس الصغيرة من المجموع النهائي. وذلك مجرد مثال واحد من بين المئات التي عدلها الباحثون طفيفاً، وخلُصت النماذج في جميعها تقريباً إلى مخرجات خاطئة.

في تفسيرهم لتلك النتائج، يفترض الباحثون أن انخفاض مستوى الدقة في الإجابات مرده إلى أن النماذج اللغوية الكبيرة غير قادرة على التفكير المنطقي بالمعنى الحرفي، إنما تحاول أن تحاكي الخطوات المنطقية الموجودة في بيانات التدريب.

تنسجم تلك التصورات مع توصيفات أُخرى ارتبطت بالنماذج اللغوية الكبيرة، والتي تشير إلى أنه وعلى الرغم من قدراتها على بناء وتتبع سلاسل معقدة للتفكير المنطقي الرياضي، إلّا أن تلك السلاسل عرضة للكسر والتقهقر إذا ما طرأت أي تعديلات سطحية.

على المقلب الآخر، أثار البحث ردود أفعال من باحثين آخرين. إذ أشار أحد الباحثين في OpenAI إلى إمكانية بلوغ الإجابات السليمة لتلك المطالبات الاختبارية في البحث عبر تزويد النماذج بدفعة أخرى من المعلومات السياقية، وهو ما قد يكون مطلوباً لنماذج الذكاء الاصطناعي كي تستطيع التعامل مع التعديلات السطحية بالطريقة السليمة.

https://twitter.com/boazbaraktcs/status/1844763538260209818#