شركة OpenAI تعترف: أدوات تمييز نصوص الذكاء الاصطناعي لا تعمل حقاً

⬤ بداية العام، أطلقت OpenAI أداة خاصة تقوم بتمييز النصوص إن كانت من كتابة البشر أو مولدة بالذكاء الاصطناعي.

⬤ سحبت الشركة الأداة الآن بعدما تبين أن فعالية كشف نصوص الذكاء الاصطناعي هي 26% فقط.

⬤ كان هناك العديد من الأدوات التي ادعت قدرتها كشف نصوص الذكاء الاصطناعي، لكن فعاليتها منخفضة جداً.

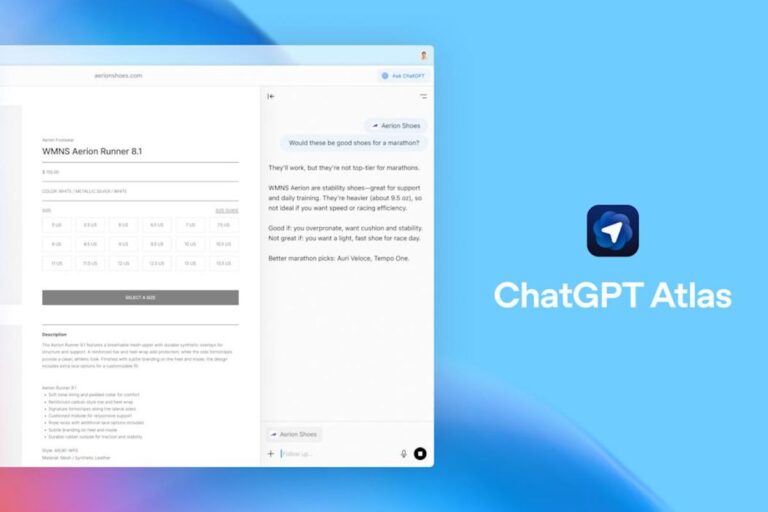

بعد شهرين تقريباً من إطلاقها روبوت المحادثة واسع الشهرة ChatGPT، أطلقت شركة OpenAI أداة تجريبية لتمييز النصوص المولدة بالذكاء الاصطناعي تسمى AI Classifier، وذلك استجابة لشكاوى المعلمين من استخدام الطلاب ChatGPT لكتابة واجباتهم المدرسية. لكن يبدو أن هذه الأداة لا تؤدي وظيفتها بالشكل المطلوب، إذ قامت OpenAI خفية بسحب AI Classifier عن الإنترنت مؤخراً.

منذ البداية، اعترفت شركة OpenAI بأن أداة AI Classifier ليست “موثوقة بالكامل”، حيث كانت الأداة تميّز 26% فقط من النصوص المولدة بالذكاء الاصطناعي على أنها “قد تكون مولدة بالذكاء الاصطناعي”، وبينما كانت تخطئ وتقول نفس الشيء عن 9% من النصوص التي كتبها البشر. والآن يبدو أن الشركة تخلّت عن الأداة بالكامل بحجة “معدل دقتها المنخفض”.

أداة AI Classifier ليست الوحيدة التي تعاني من قلة الدقة، إذ يقول مستخدمون إن أدوات مثل Turnitin وGPTZero ليست دقيقة ولا تعطي نتائج موثوقة أيضاً. فنهج عمل هذه الأدوات ليس مثبتاً، كما أن أدوات توليد النصوص بالذكاء الاصطناعي ماهرة جداً في الكتابة مثل البشر، فيكفي أن تطلب منها الكتابة بأسلوب مؤلف معروف لتستطيع خداع أدوات تمييز النصوص مثل AI Classifier.

إذ قال المؤلف دانييل جيفريز على تويتر: “إذا لم تتمكن شركة OpenAI من تطوير أداة قادرة على تمييز النصوص التي يولدها الذكاء الاصطناعي التابع لها، فلن يتمكن أي شخص آخر من ذلك. لقد قلت في السابق إن أدوات تمييز المحتوى المولد بالذكاء الاصطناعي هي كذبة تُباع للناس، وهذا مجرد دليل آخر على كلامي.”

تدعم الدراسات الحديثة كلام جيفريز، إذ وجد الكثير من المعلمين والأساتذة أن أعمالهم المكتوبة يتم تمييزها بشكل خاطئ على أنها مولدة بالذكاء الاصطناعي بفعل تلك الأدوات. كما وجدت الدراسات أن تلك الأدوات تميل إلى وصف كتابات غير الناطقين بلغة النص وأصحاب الاختلافات العصبية على أنها كتابات ذكاء اصطناعي. هذا بالإضافة إلى الحالات المتعددة التي تم اتهام الطلاب زوراً بالاستعانة بالذكاء اصطناعي بسبب نتائج خاطئة من أدوات تمييز النصوص المولدة بالذكاء الاصطناعي.

في محاولة لحل هذه المشكلة، تعهدت كبرى شركات الذكاء الاصطناعي ومنها شركة OpenAI على وضع علامات مائية في المحتوى المولد بالذكاء الاصطناعي. لكن لا يزال البحث جارياً لمعرفة فعالية هذه الخطوة، فوضع علامة مائية على نصوص الذكاء الاصطناعي عن طريق تحديد معدل تكرار الكلمات فيها مثلاً يمكن لأدوات الذكاء الاصطناعي تجاوزه بسهولة عن طريق إعادة صياغة مخرجاتها.