روبوتات المحادثة من جوجل ومايكروسوفت تنشر أخباراً كاذبة، وتستشهد ببعضها البعض

⬤ يعاني الذكاء الاصطناعي من صعوبة تمييز الحقائق، وهو ما ظهر مؤخراً في حالة تضمنت جوجل ومايكروسوفت معاً.

⬤ تضع شركات روبوتات المحادثة تحذيرات بأن المعلومات قد لا تكون دقيقة، لكن معظم المستخدمين يصدقونها على أي حال.

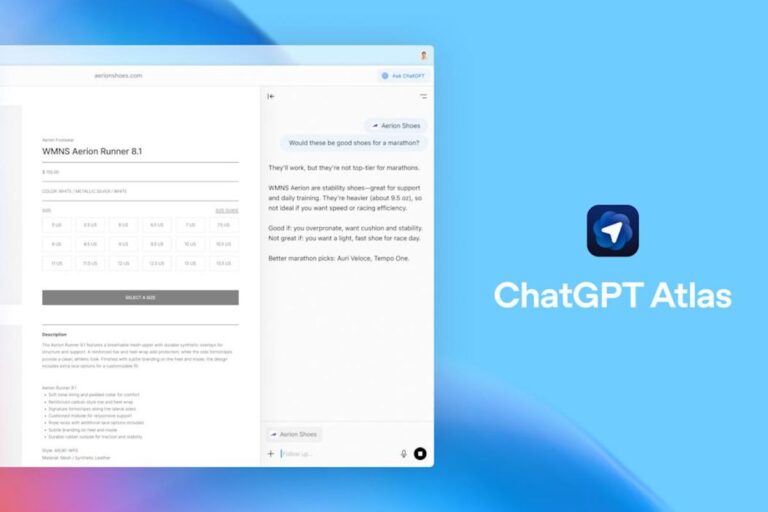

⬤ منذ نوفمبر، باتت روبوتات المحادثة القائمة على الذكاء الاصطناعي هي مجال منافسة عمالقة التقنية بسبب انتشارها السريع.

على أعتاب النجاح المتفجر لروبوت المحادثة القائم على الذكاء الاصطناعي، ChatGPT، بدأت عمالقة التقنية بسباق محموم لتكون أولى من تهيمن على المجال الجديد والناشئ عبر طرح خدماتها وتقديمها للمستخدمين بأسرع شكل ممكن. وبينما كانت مايكروسوفت هي الأولى عندما ضمنت خوارزمية GPT-4 في روبوت محادثة ضمن محرك بحثها، Bing، سرعان ما تبعتها جوجل مع ذكائها الاصطناعي المسمى Bard.

لكن وبينما أحدثت روبوتات المحادثة ثورة كبرى من حيث قدرتها على توليد الكلام واختصار المواضيع الطويلة والتفاعل باللغة الطبيعية، فقد ظهرت مشكلة كبرى في كونها لا تميز الحقيقة من الزيف، وبالنظر إلى أنها تستقي محتوى تدريبها من الإنترنت، فاحتمال نقل معلومات خاطئة أو الفهم الخاطئ للمعلومات كبيرة للغاية.

في حالة أخيرة نشرها موقع The Verge، أظهر روبوتا المحادثة الخاصين بجوجل ومايكروسوفت جانبهما السيئ عبر تناقل أخبار كاذبة، والاستشهاد ببعضهما البعض حتى.

كان محرك القصة هو سؤال محرك البحث Bing إن كان الذكاء الاصطناعي المنافس، Bard، قد توقف عن العمل. وبشكل مقنع للغاية، كان جواب Bing هو نعم، وقدم تواريخ وأسباب تبدو مقنعة للغاية. لكن بالنظر إلى أن الإجابة خاطئة تماماً، كان لا بد من البحث عن أصلها وطريقة بدايتها.

بدأ الأمر من تعليق ساخر على منتدى Hacker News حيث قال أحد المستخدمين أنه يتخيل توقف الذكاء الاصطناعي الخاص بجوجل بعد عام واحد (مشيراً إلى عادة جوجل بإيقاف العديد من الخدمات بعد فترات قصيرة من إطلاقها)، ليقوم مستخدم آخر باستخدام ChatGPT لإنشاء خبر مزيف ومقنع عن الأمر ويضع النتيجة في تعليق. لاحقاً، قام أحد المستخدمين بسؤال ذكاء جوجل الاصطناعي، Bard، عن نفسه إن كان قد توقف، وبشكل صادم أجاب أنه قد توقف حقاً، واستشهد بالتعليق سابق الذكر، وهو ما دفع المستخدم لنشر تغريدة يتناول فيها هذا الخطأ. ومن هنا تم تغطية التغريدة في خبر على موقع Windows Central، ليقوم الذكاء الاصطناعي الخاص بمايكروسوفت بفهم الخبر بشكل خاطئ واستخدامه كدليل على أن Bard قد توقف حقاً.

في حال كان ما سبق محيراً، فالشرح المبسط هو أن الذكاء الاصطناعي (Bing) نشر معلومة كاذبة مستشهداً بخبر ساخر من كون الذكاء الاصطناعي (Bard) ينشر معلومات خاطئة، وكان الذكاء الاصطناعي (Bard) الذي نشر تلك المعلومة الخاطئة قد استشهد بتعليق ساخر تمت كتابته باستخدام ذكاء اصطناعي ثالث (ChatGPT).

يبدو كل ما سبق مقلقاً للغاية بحد ذاته، لكن الأمر يصبح أسوأ عندما نأخذ بعين الاعتبار أن كل ذلك كان قد جرى بالخطأ ودون قصد. لكن عندما يبدأ المستخدمون بالتضليل المقصود للذكاء الاصطناعي، وهو ما سيحدث دون شك، وبالأخص في المواضيع الجدلية مثل السياسة والاقتصاد وسواها، ستكون النتائج أسوأ بمراحل من الآن.

تقوم مختلف خدمات روبوت المحادثة بوضع تحذيرات من أنها قد لا تكون دقيقة تماماً من حيث الحقائق. لكن وبالنظر إلى أنها تقدم ضمن محركات البحث التي يستخدمها الأشخاص بشكل محدد لمعرفة المعلومات، تعرف الشركات تماماً أن المستخدمين سيصدقون روبوتات المحادثة وما تقدمه من معلومات خاطئة وأخبار كاذبة.