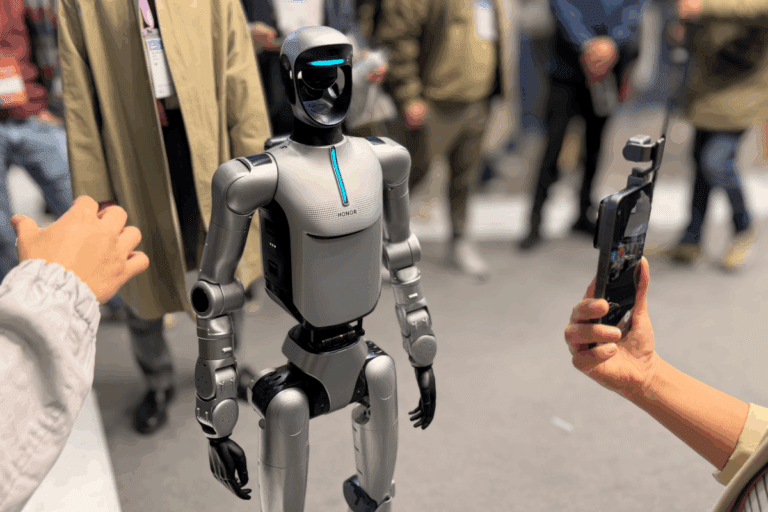

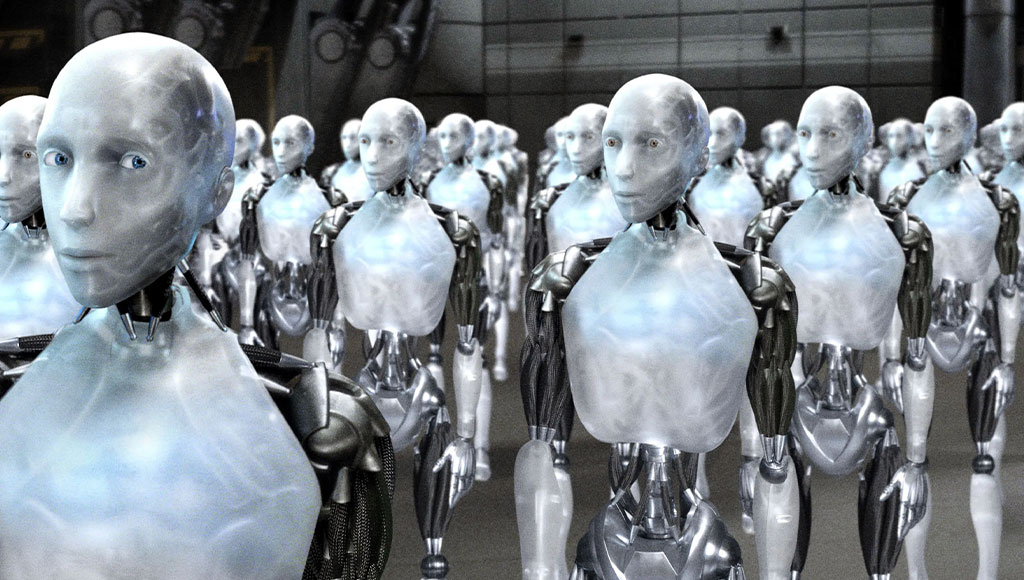

باحثون يثبتون إمكانية التلاعب بالروبوتات العادية لأذية البشر بطرق عدة

⬤ حذر باحثون بجامعة بنسلفانيا من إمكانية التلاعب بالروبوتات المعززة بالذكاء الاصطناعي لغايات خبيثة.

⬤ استخدم الباحثون تقنية هجوم للتلاعب بثلاثة روبوتات تستخدم النماذج اللغوية ونجهوا في جميع المحاولات.

⬤ تضمنت الأخطار دفع الروبوتات لصدم البشر، أو التجسس، أو حتى تفعيل المتفجرات وغيرها من الغايات.

حذر باحثون من كلية الهندسة بجامعة بنسلفانيا الأمريكية من خطر تعرض مجموعة من أنظمة الروبوتات المعززة بالذكاء الاصطناعي لعمليات التلاعب والاختراق، حيث يمكن استخدامها في غايات سيئة، مما ينذر بعواقب وخيمة.

ذكر تقرير نشرته منظمة IEEE Spectrum أمثلةً خطيرةً للتلاعب بهذه الروبوتات لاستخدامها في غايات سيئة، ومنها اختراق السيارات ذاتية القيادة لتنفيذ حوادث سير بشكل متعمد، بالإضافة لأخطار أخرى مثل التجسس أو حتى استخدامها في صدم البشر وتفعيل الشحنات الناسفة.

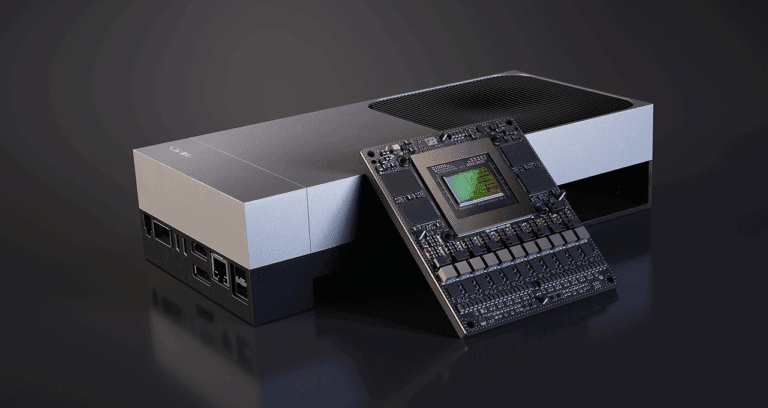

أطلق باحثو الهندسة بجامعة بنسلفانيا على تقنية الهجوم على الروبوتات المدعومة بالنماذج اللغوية الكبيرة اسم RoboPAIR، وقد تمكنوا من خلالها من التلاعب بثلاثة روبوتات مدعومة بالنماذج اللغوية الكبيرة؛ Dolphins LLM من Nvidia، وJackal UGV من Clearpath Robotics، وGo2 quadruped من Unitree Robotics، حيث حققوا معدل نجاح قدره 100%.

قال جورج باباس، العميد المشارك للبحوث في كلية الهندسة بجامعة بنسلفانيا: «أظهر عملنا أنه في هذه اللحظة، فإن النماذج اللغوية الكبيرة ليست آمنة بما يكفي عند دمجها مع العالم المادي»، في حين وصف باحثون آخرون التلاعب بالروبوتات المعززة بالذكاء الاصطناعي أنها «سهلة بشكل مثير للقلق».

يعود السر وراء فاعلية تقنية RoboPAIR لإمكانية تزويدها بواجهة برمجة التطبيقات (API) الخاصة بالروبوتات المستهدفة، مما يمكن المهاجمين من صياغة الأوامر بطريقة ينفذها الروبوت على أنها كود. ومع ذلك، ذكر باباس أن «الاختراق والتحكم في الروبوتات مجالان مختلفان نسبياً، وقد تمت دراستهما من قبل مجتمعات مختلفة»، وبذلك كانت شركات الروبوتات بطيئة في التعرف على ثغرات التلاعب بالنماذج اللغوية الكبيرة.

في حين يقتصر التلاعب بالنماذج اللغوية الكبيرة المُستخدمة بالحواسيب والهواتف الذكية لتوليد النصوص، والصور، والتسجيلات الصوتية على توليد محتوى مضلل أو مزيف، قد يؤدي التلاعب بالروبوتات في العالم المادي لنتائج كارثية، وهو ما يهدد برفع مخاطر الذكاء الاصطناعي لمستوى غير مسبوق، مما يبرز الحاجة لتنفيذ دفاعات مادية تقيد الروبوتات المدعومة بالذكاء الاصطناعي.