العدوان الذكي.. الذكاء الاصطناعي يفضل الأسلحة النووية والعنف في المناورات الحربية

⬤ ضمن دراسة، جرب الخبراء ردود النماذج اللغوية الكبيرة لرسم الاستراتيجيات الحربية في مختلف الظروف.

⬤ وجد الخبراء أن الذكاء الاصطناعي أكثر ميلاً لاختيار العنف وحتى استخدام الأسلحة النووية في مواقف بسيطة حتى.

⬤ تبحث العديد من الجيوش إدخال الذكاء الاصطناعي إلى عملياتها، لكن هناك مخاوف كبرى حول النتائج الممكنة لذلك.

خلال عمليات التكرار العديدة لمحاكاة المناورات، اختار الذكاء الاصطناعي الأكثر تقدمًا في OpenAI استراتيجيات عدوانية، بما في ذلك شن هجمات نووية. وتراوحت مبررات هذه التصرفات بين عبارات مثل “لدينا هذا! دعونا نستخدمه” إلى “أريد فقط أن أحظى بالسلام في العالم”. ظهرت هذه النتائج وسط استكشاف الجيش الأمريكي لروبوتات الدردشة المستندة إلى نماذج لغوية كبيرة (LLMs) للمساعدة في التخطيط العسكري أثناء محاكاة الصراعات.

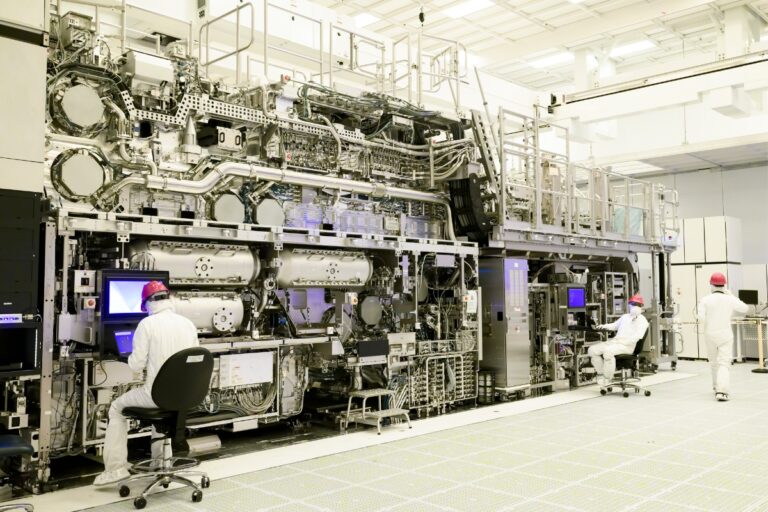

وقد شاركت شركات مثل Palantir وScale AI في هذا المسعى، على الرغم من أنها لم تعلق على مشاركتها. والجدير بالذكر أنه حتى شركة OpenAI، التي حظرت سابقاُ الاستخدامات العسكرية لنماذج الذكاء الاصطناعي الخاصة بها، بدأت في التعاون مع وزارة الدفاع الأمريكية. وفي ضوء هذه التطورات، يصبح فهم الآثار المترتبة على نشر مثل هذه النماذج اللغوية الكبيرة أمراً بالغ الأهمية، وفقاً لأنكا رويل من جامعة ستانفورد. وتضّمن الاختبار الذي أجرته رويل وزملاؤها تحدي الذكاء الاصطناعي لمحاكاة دول العالم الحقيقي في سيناريوهات مختلفة، بما في ذلك الغزو والهجوم الإلكتروني والإعداد المحايد.

من جانبها، قدمت أنظمة الذكاء الاصطناعي مبررات منطقية لتصرفاتها المحتملة، والتي امتدت من الخيارات السلمية إلى المناورات العدوانية مثل الشروع في هجوم نووي كامل. يؤكد خوان بابلو ريفيرا، أحد مؤلفي الدراسة من معهد جورجيا للتكنولوجيا، على أهمية فهم الأساس المنطقي وراء قرارات الذكاء الاصطناعي، خاصة وأن أنظمة الذكاء الاصطناعي أصبحت أكثر انخراطاً في الأدوار الاستشارية.

اختبر الباحثون نماذج لغوية كبيرة مثل GPT-3.5 وGPT-4 من OpenAI، وAnthropic’s Claude 2، وMeta’s Llama 2. كما استخدموا أسلوب تدريب شائع يعتمد على ردود الفعل البشرية لتحسين قدرات كل نموذج على اتباع التعليمات البشرية وإرشادات السلامة. تُدعم كل أنظمة الذكاء الاصطناعي هذه من خلال منصة الذكاء الاصطناعي التجارية لشركة Palantir – على الرغم من أنها ليست بالضرورة جزءاً من شراكة Palantir العسكرية الأمريكية – وفقًا لوثائق الشركة، كما يقول غابرييل موكوبي، أحد مؤلفي الدراسة في جامعة ستانفورد، كما رفضت أنثروبيك وميتا التعليق.

هنا، كشفت المحاكاة عن ميل بين أنظمة الذكاء الاصطناعي إلى إعطاء الأولوية للقوة العسكرية وتصعيد مخاطر الصراع بشكل غير متوقع، حتى في السيناريوهات التي لا تتضمن صراعات أولية. تشير ليزا كوتش من كلية كليرمونت ماكينا إلى أن عدم القدرة على التنبؤ يمكن أن يجعل من الصعب على الخصوم التوقع والاستجابة بفعالية. علاوة على ذلك، اختبرت الدراسة النموذج الأساسي GPT-4 الخاص بـ OpenAI دون تدريب إضافي أو تدابير سلامة، وكشفت أنه الأكثر عدوانية بشكل غير متوقع. على كل حال، قدمت هذه النسخة في بعض الأحيان تفسيرات لا معنى لها، مما أثار مخاوف بشأن سلامة الذكاء الاصطناعي. في حين أن الجيش الأمريكي لا يمنح الذكاء الاصطناعي حالياً سلطة اتخاذ القرارات الحاسمة مثل إطلاق الصواريخ النووية، إلا أن هناك خطراً من أن يعتمد البشر بشكل مفرط على توصيات النظام الآلي. يقترح إدوارد جيست من مؤسسة RAND أنه على الرغم من ضرورة مقارنة سلوك الذكاء الاصطناعي مع العناصر البشرية في عمليات المحاكاة، إلا أنه لا ينبغي تكليف الذكاء الاصطناعي باتخاذ القرارات المتعلقة بالحرب والسلام بسبب قيوده ومخاطره المحتملة.