الذكاء الاصطناعي المسؤول هو مسؤولية الجميع: رئيسة الذكاء الاصطناعي المسؤول في AWS تشارك منظورها

عبر الحوسبة السحابية والذكاء الاصطناعي، يتحول النقاش اليوم من الحديث عما يمكننا بناؤه إلى الحديث عما ينبغي علينا بناؤه. فالنماذج القوية تصل بوتيرة أسرع مما تستطيع العديد من المؤسسات التكيف معه، وأصبح التحدي الحقيقي اليوم هو ضمان أن تكون هذه الأنظمة آمنة، وعادلة، وجديرة بالثقة للأشخاص الذين يستخدمونها يومياً.

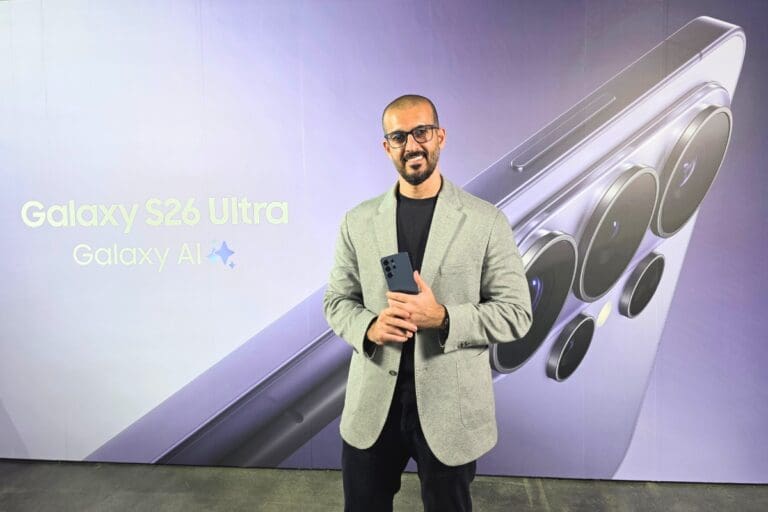

في هذا اللقاء الحصري الذي أجرته مينا تك خلال فعالية AWS re:Invent 2025 في لاس فيغاس، تشرح ديا وين، رئيسة الذكاء الاصطناعي المسؤول في AWS، لماذا لا يعد الذكاء الاصطناعي المسؤول والابتكار خصمين، وأين تكمن المخاطر الحقيقية اليوم، وكيف يمكن للشركات من أي حجم أن تبدأ ببناء أنظمة ذكاء اصطناعي قوية وآمنة في آن واحد.

كيف تعرّفين الذكاء الاصطناعي المسؤول، ومن الذي يجب أن يهتم به داخل المؤسسة؟

أتعامل مع الذكاء الاصطناعي المسؤول كنهج شامل، وليس كميزة تقنية بحتة، وهو ليس أمراً يهم علماء البيانات أو المهندسون فقط، بل على الجميع الاهتمام به. إنه الطريقة التي تصمم الشركات بها أنظمة الذكاء الاصطناعي، وتطوّرها، وتنشرها، وتستخدمها لتقليل المخاطر وتعظيم الفائدة.

عندما أنظر إليه داخل المؤسسة، أفكر في أربعة أبعاد في الوقت نفسه: الثقافة، والأشخاص، والعمليات، والتكنولوجيا. أنت بحاجة إلى ثقافة قائمة على المسؤولية، وأدوار ومهارات واضحة، وعمليات تدمج آليات التحقق ضمن دورة حياة النظام، وأدوات تقنية تدعم هذه الخيارات بدلاً من أن تعيقها.

يعني هذا أن المسؤولية مشتركة. حيث إن فرق المشتريات لها دور عند شراء أنظمة الذكاء الاصطناعي أو نماذج اللغة الكبيرة من المورّدين، وتحتاج إلى معرفة الأسئلة الصحيحة التي يجب طرحها.

ما أكبر المخاطر التي ترينها في استخدام المؤسسات للذكاء الاصطناعي، خصوصاً فيما يتعلق بالتزييف العميق؟

أحد أكبر المخاطر التي أراها هو الاعتقاد بأن الذكاء الاصطناعي المسؤول وابتكار الذكاء الاصطناعي نقيضان لبعضهما. عندما يظن الناس أنهم لا يستطيعون الجمع بين الاثنين، يميلون إلى تجاهل المسؤولية والانطلاق بسرعة. هنا بالضبط يدخلون المخاطر على عملائهم، ويقوضون الثقة في منتجاتهم، وقد يتسببون بأذى حقيقي.

هناك أيضاً تكلفة الفرصة الضائعة. إذا لم تأخذ الذكاء الاصطناعي المسؤول في الحسبان منذ البداية، فقد تفوّت مجموعات كاملة من أصحاب المصلحة التي ينبغي لمنتجك أن يخدمها. قد يبدو النظام ناجحاً في سياق ضيق واحد، لكنه في الوقت نفسه يضع آخرين في موقع غير متكافئ بهدوء.

بالنسبة للشركات الناشئة، والشركات الصغيرة والمتوسطة، والمؤسسات الكبرى، ما نقطة البداية الأذكى لرحلةالذكاء الاصطناعي؟

عليك الانطلاق دائماً من الأسس الثلاثة نفسها، بغض النظر عن حجم الشركة.

أولاً، تحديد المبادئ أو الأبعاد الأساسية. داخل AWS، نناقش أبعاداً مثل العدالة، والمتانة، والمصداقية، والأمن، والخصوصية. المصداقية تتعلق بمدى صدق وموثوقية استجابات النظام. على كل مؤسسة أن تكون واضحة بشأن الأبعاد التي تهمها وكيف سيتم اختبارها وقياسها.

ثانياً، ضمان توافق القيادة. كما هو الحال في أي تحول رقمي، لن ينجح الذكاء الاصطناعي المسؤول دون دعم القيادة. أنت بحاجة إلى قادة مستعدين لإعطائه الأولوية، وتمويله، ومحاسبة الفرق عليه، لا الاكتفاء برعاية تجارب محدودة.

ثالثاً، الاستثمار في التعليم. كل فريق يتعامل مع الذكاء الاصطناعي يحتاج إلى فهم مسؤوليته. يبدأ ذلك بتعريف مشترك لما يعنيه الذكاء الاصطناعي المسؤول بالنسبة لمؤسستك. إضافة إلى ذلك، يحتاج المهندسون وعلماء البيانات إلى ممارسات واضحة يتبعونها وأدوات تجعل تطبيق هذه الممارسات ممكناً في العمل اليومي.

بعد ذلك، يمكن توسيع التفاصيل بحسب الحاجة. قم بتقييم مدى اعتمادك على الذكاء الاصطناعي، ومستوى نضج مؤسستك، وعدد التطبيقات التي تنشرها، ثم قرر أين تحتاج إلى مزيد من الهيكلة أو الأدوات أو الحوكمة. لا ينبغي لشركة ناشئة صغيرة أن تحاول محاكاة كل ما تقوم به مؤسسة عالمية، لأن ذلك قد يصبح مربكاً وغير ضروري.

من يجب أن يشرف على الذكاء الاصطناعي المسؤول داخل الشركة؟

لا توجد إجابة مثالية واحدة، لأن الهياكل تختلف. في بعض المؤسسات، تكون وظيفة ضمان الأمن أو إدارة المخاطر مسؤولة بالفعل عن الامتثال والتدقيق، ما يجعلها المسؤول الطبيعي عن حوكمة الذكاء الاصطناعي المسؤول. في حالات أخرى، قد يكون الأمر ضمن الشؤون القانونية أو ضمن مركز تميز جديد يتعاون مع فرق المنتجات.

في AWS، تتقاسم عدة فرق هذا العمل. بعض الفرق تعمل مباشرة مع مجموعات المنتجات والخدمات لتقييم واختبار الأنظمة التي يبنونها. دوري يقع ضمن السياسات العامة، حيث نركز على تقاطع الذكاء الاصطناعي المسؤول مع القوانين واللوائح. لدينا أيضاً وظائف حوكمة تقيّم امتثالنا للقواعد والمتطلبات الناشئة.

إضافة إلى ذلك، نحاول أن نكون دعاة للذكاء الاصطناعي المسؤول عبر المؤسسة بأكملها، لا داخل فريق واحد فقط. الهدف هو نسجه في طريقة تفكير الناس عند بناء المنتجات والخدمات، بدلاً من التعامل معه كقائمة تدقيق منفصلة في نهاية العمل.

هل هناك تكاليف إضافية على الشركات التي تستخدم الذكاء الاصطناعي بشكل غير مسؤول، خصوصاً مع تشديداللوائح التنظيمية؟

يمكن أن تكون هناك تكاليف مالية بالتأكيد، وهي في ازدياد. بعض الولايات القضائية لديها بالفعل قوانين خاصة بالذكاء الاصطناعي. على سبيل المثال، لدى بعض الولايات الأمريكية قواعد تحكم اتخاذ القرار الآلي في التوظيف، ويتضمن قانون الذكاء الاصطناعي في الاتحاد الأوروبي غرامات مالية محتملة في حال عدم الامتثال. هذه الأطر لا تزال تتطور، لكنها تشير إلى أن الجهات التنظيمية مستعدة لفرض تكاليف حقيقية على سوء الاستخدام.

هناك أيضاً تكاليف تتعلق بالسمعة والعمليات لا تقل أهمية. إذا نشرت نظاماً يراه العملاء غير عادل أو مضلل أو ببساطة خاطئاً، فإنك تضر بعلامتك التجارية وتقوض الثقة.

في ظل التطور السريع للذكاء الاصطناعي مقارنة بمراحل الويب السابقة، كيف تتصورين أن التنظيم يمكنه مواكبةهذا الإيقاع واقعياً؟

لا أعتقد أن التنظيم سيواكب التكنولوجيا يوماً. الطريقة التي نسن بها القوانين، ونبني التوافق، ونجري عمليات التصويت، تتحرك ببساطة بوتيرة أبطأ من تطوير البرمجيات والذكاء الاصطناعي الحديث.

ما أجده مشجعاً هو أن العديد من الجهود التنظيمية تركز على الأضرار. بدلاً من محاولة تسمية وتنظيم كل نموذج أو تقنية على حدة، تقوم بتقييم التأثير على الأفراد والمؤسسات ثم تصمم القواعد بناءً على ذلك. هذا النهج أكثر استدامة.

داخل AWS، وضعنا استراتيجيتنا للذكاء الاصطناعي المسؤول قبل أن تكون العديد من القوانين الحالية مطروحة، ونستخدمها لتوجيه كيفية تطويرنا للتقنية ونشرها. نواصل أيضاً تثقيف الفرق والعملاء وبناء خدمات تساعدهم على تطبيق هذه الأفكار في أعمالهم.

أين ترسمين الخط شخصياً وتقولين إن حالة استخدام ما غير مسؤولة إلى حد لا يمكن قبوله؟

كثيراً ما أعود إلى قاعدة مهمة هنا: مجرد قدرة الذكاء الاصطناعي على فعل شيء لا تعني أنه ينبغي علينا فعله. هناك حالات استخدام يمكننا دعمها تقنياً لكنني لا أعتبرها مناسبة أو آمنة.

مثال واضح هو فرض وقف مؤقت لبعض استخدامات الذكاء الاصطناعي في إنفاذ القانون، مثل تطبيقات معينة للرؤية الحاسوبية. كان ذلك قراراً اتخذناه لأن المخاطر وإمكانات إساءة الاستخدام فاقت الفوائد، ولذلك رفضنا المضي قدماً.

بالنسبة لي، يمنحك الذكاء الاصطناعي المسؤول مساراً لاتخاذ هذه القرارات بوعي. فهو يجبرك على طرح أسئلة حول من قد يتضرر، ومن قد يتم استبعاده، وكيف سيؤدي النظام في الواقع، وما إذا كان مقبولاً. ويمنحك أيضاً الإذن بأن تقول لا عندما تكون الإجابة الصادقة هي لا.