شركة Google تكشف للمرة الأولى عن ملامح نظامها المخصص لنظارات الواقع الموسع

⬤ استعرضت Google خلال مؤتمر TED2025 نموذجاً أولياً لنظارات ذكية مدعومة بالذكاء الاصطناعي ومنصة Android XR.

⬤ أظهرت النظارات قدرات متقدمة تشمل الترجمة الفورية، والذاكرة البصرية، والتحليل السياقي للمحتوى المرئي والمسموع.

⬤ تسعى Google بالتعاون مع سامسونج إلى تطوير تقنيات واقع معزز أكثر تطوراً رغم التحديات التقنية القائمة.

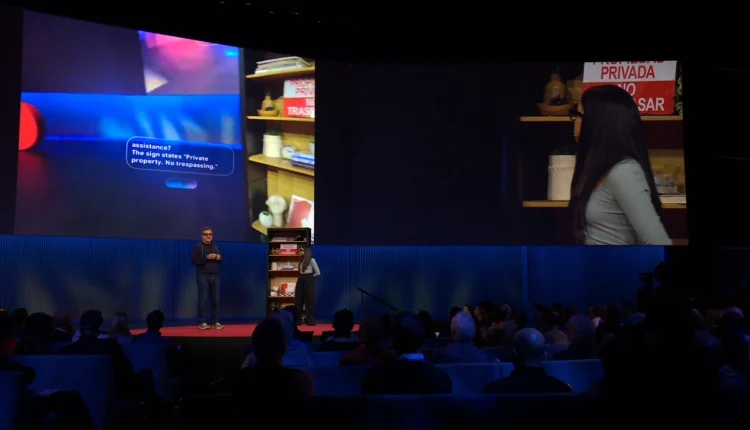

ضمن فعاليات مؤتمر TED2025، وضعت شركة Google بصمتها الواضحة عبر استعراض حي لنظارات ذكية مدعومة بالذكاء الاصطناعي، مقدمة بذلك رؤية ملموسة لمستقبل تقنيات الواقع المعزز، ضمن سباق متسارع نحو الجيل القادم من التقنيات القابلة للارتداء بين عمالقة التقنية، مثل Meta وApple وسامسونج.

يعتمد النموذج الأولي للنظارات الذكية تلك على منصة Google الجديدة Android XR، مدعومة بإمكانيات ذكاء Gemini الاصطناعي.

خلال عرض قدمه نائب الرئيس والمدير العام لتقنيات الواقع الموسع في Google، شهرام إزادي، إلى جانب مديرة المنتجات، نيشتا باتيا، استعرض إزادي استخداماً عملياً للنظارات، حيث عرض ملاحظاته الخاصة بالمحاضرة مباشرة أمام عينيه عبر شاشة «داخل العدسة.»

جاء التصميم شبيهاً بالنظارات التقليدية، لكن بحجم أكبر قليلاً، مع مراعاة خفة الوزن، وإمكانية دعم العدسات الطبية. ويضم كاميرا صغيرة الحجم، وميكروفونات، وسماعات مدمجة.

بضغطة بسيطة على ذراع النظارات، تتفعل قدرات Gemini، لتبدأ سلسلة من العروض الحية التي أظهرت قدرات تتجاوز الأوامر الصوتية التقليدية، ومنها الخيال الإبداعي الفوري عند الطلب، والذاكرة البصرية النشطة، إذ تمكنت النظارات على سبيل المثال من التعرف على عنوان كتاب تمت رؤيته قبل لحظات، والمساعدة في تحديد موقع بطاقة مفتاح ضائعة باستخدام معالجة بصرية فورية مستلهمة من مفهوم مشروع Project Astra التابع لقسم Google Deepmind.

هنالك أيضاً ترجمة متعددة اللغات في الوقت الحقيقي، وقد أظهرت النظارات في العرض قدرتها على الترجمة من الإنجليزية إلى الفارسية، وعند الانتقال المقدمين للحديث بالهندية، تولى Gemini الترجمة مباشرة دون الحاجة لتغيير الإعدادات يدوياً، لكن، مع التنويه بإمكانية وجود بعض التفاوت في الأداء حالياً.

تمتاز النظارات أيضاً بفهم سياقي متقدم، إذ أمكنها على سبيل المثال التعرف على غلاف ألبوم لأحد المغنين، وعرض تشغيل إحدى مقطوعاته عبر تطبيق YouTube Music المدمج. إلى جانب قدرات تحليل بصري ذكي تجلى في تحويل المخططات والنصوص المرئية إلى ملخصات صوتية سهلة الفهم.

تضمن العرض أيضاً ميزات واعدة تتجاوز مجرد التفاعل مع الذكاء الاصطناعي. إذ تم عرض طبقة شبه هولوجرافية من Google Street View تظهر مباشرة أمام عين المستخدم لتسهيل التنقل، كما جرى إظهار قدرات النظارات على الاتصال بالهاتف الذكي، للاستفادة من قوته الحاسوبية، والوصول إلى التطبيقات المختلفة، بما في ذلك تكامل مباشر مع خدمات Google مثل YouTube Music وMaps.

يعمل النموذج الذي تم عرضه على نظام Android XR، والذي كشفت Google عنه في ديسمبر الماضي، بهدف إنشاء منصة موحدة ومفتوحة لأجهزة الواقع الممتد، يمكن من خلالها دمج تطبيقات Google الشهيرة مثل YouTube وPhotos وMaps وChrome ضمن بيئات ثلاثية الأبعاد أو شاشات افتراضية، مع دعم التفاعل بالإيماءات والصوت والإشارات البصرية، فضلاً عن التوافق مع تطبيقات Android التقليدية.

تشير التقارير إلى أن هذه النظارات قد لا تكون المنتج الوحيد ضمن استراتيجية Google الجديدة في مجال الواقع المعزز، حيث تعمل الشركة بالتعاون مع سامسونج على مشروع يُعرف باسم Project Moohan، ومن المعتقد أنه يستهدف تقديم تجربة أكثر تطوراً وشبيهة بنظارات Apple Vision Pro، ومدعومة أيضاً بذكاءGemini.

رغم الحماسة التي أثارها العرض، فقد سلط الضوء أيضاً على التحديات التقنية التي ما زالت قائمة. فابتكار نظارات واقع معزز ذات جاذبية جماهيرية يتطلب تحقيق توازن دقيق بين تقنيات العرض المتقدمة، والتي يتعين أن تكون أكبر وأذكى مما تم عرضه، وبين عوامل جوهرية مثل عمر البطارية وخفة الوزن. وإذا تمكنت Google وشركاؤها من تجاوز هذه العقبات، فإن حلم الواقع المعزز الفعال وغير المزعج قد يصبح أقرب من أي وقت مضى للخروج من المختبرات ودخول الحياة اليومية.