Google تطور خوارزمية ذكاء اصطناعي للألعاب تستجيب لأوامر اللغة الطبيعية

⬤ طورت شركة DeepMind التابعة لشركة Google نموذج ذكاء اصطناعي قادر على تعلم الألعاب والاستجابة لأوامر اللغة الطبيعية.

⬤ تم تدريب نموذج SIMA على تسع ألعاب أساسية، حيث يراقب الخرج المعروض للألعاب ويقدم توجيهات لوحة المفاتيح والفأرة للعب.

⬤ لا يزال النموذج غير مثالي حالياً، لكنه ربما يفتح الباب أمام طريقة جديدة من التفاعل مع الألعاب، وبالأخص بالنسبة لمن يعانون صعوبات الوصول.

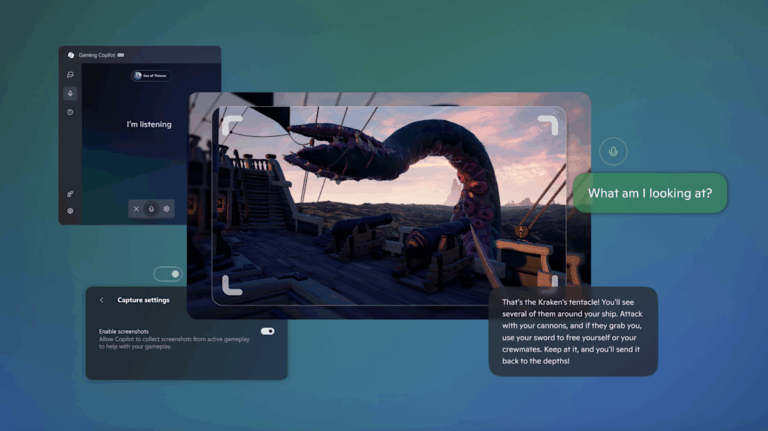

أنشأت مجموعة أبحاث DeepMind التابعة لشركة Google نموذجاً جديداً للذكاء الاصطناعي يسمى SIMA، والذي يرمز إلى Scalable, Instructable, Multiworld Agent. على عكس عملاء الذكاء الاصطناعي الآخرين الذين جرى تدريبهم للسيطرة على ألعاب معينة، صُمم SIMA للتفاعل مع أي بيئة ثلاثية الأبعاد عامة، والاستجابة لأوامر اللغة الطبيعية.

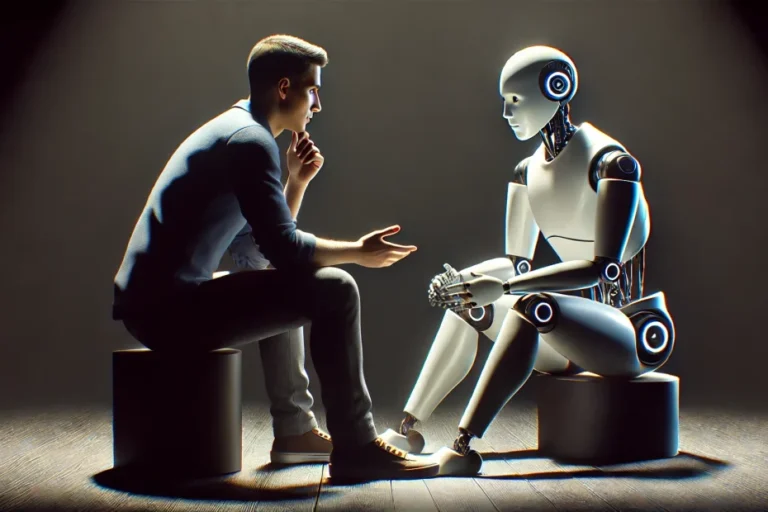

الهدف هو إنشاء عملاء ذكاء اصطناعي يمكن للاعبين إرشادهم، والتحدث إليهم في مواقف اللعب التعاوني، بدلاً من مجرد خصوم خارقين. ولتدريب SIMA، ركز فريق DeepMind على الألعاب ثلاثية الأبعاد وبيئات الاختبار التي يتم التحكم فيها إما من منظور الشخص الأول أو من منظور الشخص الثالث.

تعطي الألعاب التسع في مجموعة الاختبار الخاصة بها الأولوية «للتفاعلات المفتوحة»، وتوفر نطاقاً واسعاً من البيئات والتفاعلات المختلفة. كما لا يُمنح الوكيل أي وصول مميز إلى البيانات الداخلية للعبة، أو واجهات برمجة تطبيقات التحكم، ولا يأخذ سوى وحدات البكسل التي تظهر على الشاشة كمدخل له، ولا يوفر سوى عناصر تحكم لوحة المفاتيح والماوس كمخرجات.

يستخدم SIMA فيديو لطريقة لعب بشرية مشروحة بأوصاف باللغة الطبيعية، لما يحدث في اللقطات لبيانات التدريب. وتركز المقاطع على «التعليمات التي يمكن إكمالها في أقل من 10 ثوانٍ تقريباً» لتجنب التعقيد. كما يساعد التكامل مع النماذج المدربة مُسبقاً مثل SPARC وPhenaki، نموذج SIMA على تجنب الاضطرار إلى تعلم كيفية تفسير البيانات اللغوية، والمرئية، من البداية.

أما لاختبار قدرات التعلم الخاصة بـ SIMA، فدربه باحثو DeepMind واختبروه، على ما يقرب من 1500 مهمة فريدة من نوعها في اللغة الطبيعية، عبر تسع فئات من المهارات تتراوح من الحركة، والملاحة، إلى جمع الموارد وإدارة الأشياء. بعد ذلك، يجري تقييم أداء النموذج في هذه المهام بشكل أساسي من خلال مزيج من تقييمات «الحقيقة الأرضية»، والتقييمات البشرية.

تباين نجاح SIMA بشكل كبير عبر أنواع مختلفة من الأوامر، حيث بلغ النجاح حوالي 75 بالمائة في مهام القيادة مقابل 40 بالمائة في مهام المشي، على سبيل المثال. ومع ذلك، فإن عميل SIMA الذي دُرب على جميع الألعاب التسع في مجموعة الباحثين «تفوق بشكل كبير على العملاء المتخصصين المدربين فقط على كل لعبة على حدة، مما أظهر قدرة شاملة أكبر.»

يقدر التقرير الفني بأن SIMA تحسن بنسبة 67 بالمائة، عندما يتم تضمين الألعاب الخارجية في بيانات التدريب، وهي علامة على «الانتقال الإيجابي» عبر بيئات مختلفة تكون بمثابة معلم رئيسي في نتائج SIMA. حتى مع مجموعة التدريب الكاملة المكونة من تسع مباريات، لا يزال هناك طريق طويل لنقطعه قبل أن يتمكن عميل مثل SIMA من محاكاة قدرة الإنسان على اتباع التعليمات داخل اللعبة.

مع المزيد من التدريب على نطاق أوسع من البيئات المحاكاة، يأمل فريق SIMA أن تصبح الإصدارات المستقبلية من النموذج أكثر تعميماً وتنوعاً، وقادرة على إكمال المهام التي تتطلب تخطيطًا استراتيجياً عالي المستوى ومهام فرعية متعددة. من خلال ربط أوامر اللغة الطبيعية بالبيئات المحاكاة، تأمل DeepMind أن تتمكن إصدارات SIMA في النهاية من توفير اختبار لـ «نماذج الأساس المستقبلية» التي تؤسس القدرات المجردة لنماذج اللغة الكبيرة في البيئات المتجسدة، أي العالم الحقيقي. وكما يشير منشور مدونة Google: «على الرغم من أن النماذج اللغوية الكبيرة قد أدت إلى ظهور أنظمة قوية يمكنها التقاط المعرفة حول العالم وإنشاء الخطط، إلا أنها تفتقر حالياً إلى القدرة على اتخاذ الإجراءات نيابةً عنا.»