بدلاً من الرياضيات والمنطق، الباحثون يختبرون الذكاء الاصطناعي بلعبة Super Mario

⬤ اختبر باحثون قدرة الذكاء الاصطناعي على التكيف السريع عبر لعبة Super Mario Bros الكلاسيكية.

⬤ تفوق نموذج Claude 3.7 في الاستجابة السريعة وتخطيط القفزات، وواجهت نماذج أخرى صعوبة واضحة.

⬤ أثارت التجربة تساؤلات حول مدى ارتباط اختبارات الألعاب بقدرات الذكاء الاصطناعي في العالم الحقيقي.

في ظل التطور المستمر لمحاولات قياس قدرات الذكاء الاصطناعي، يتجه الباحثون نحو نهج جديد يتجاوز الاختبارات الرياضية الجافة، ليصل إلى ساحة أكثر متعة، ولكنها في الوقت ذاته غاية في الصعوبة، وهي الألعاب.

بعد أن رأينا كيف اختبرت Anthropic أحدث نماذجها Claude 3.7 Sonnet في لعبة Pokémon، جاءت محاولة جديدة مع لعبة Super Mario Bros الكلاسيكية، التي أطلقتها Nintendo عام 1985، وأصبحت الآن ميداناً جديداً لاختبار إمكانيات الذكاء الاصطناعي، ما يعكس تحولاً من الألغاز المنطقية التقليدية إلى تحديات القفز.

يأتي هذا النهج الجديد من مختبر Hao AI في جامعة كاليفورنيا في سان دييغو، حيث أجرى الباحثون اختباراً لمجموعة من نماذج الذكاء الاصطناعي المتطورة باستخدام Super Mario كأداة تقييم. وبدلاً من المعايير التقليدية، قرر الفريق تقييم الذكاء الاصطناعي في بيئة يفهمها البشر بشكل فطري.

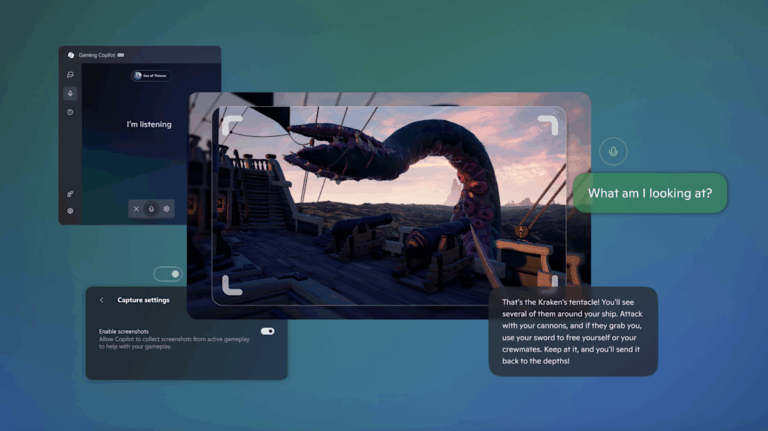

لتحقيق ذلك، استخدموا إصداراً من اللعبة يعمل ضمن محاكٍ، مدمجاً بنظام GamingAgent، وهو إطار عمل مخصص طوره المختبر، يقدم للنماذج الذكية تعليمات التحكم الأساسية وظروف التوجيه، إلى جانب لقطات شاشة في الوقت الفعلي لمجريات اللعبة، حيث تولّت النماذج مسؤولية اللعب عبر توليد أكواد بلغة البرمجة Python تتحكم بحركات ماريو.

https://twitter.com/haoailab/status/1895557913621795076

رغم بساطة Super Mario Bros كلعبة مغامرة، اكتشف الباحثون في مختبر Hao AI أنها تتطلب من الذكاء الاصطناعي تخطيطاً معقداً وتكيفاً سريعاً مع المستجدات. إذ لا يتعلق الأمر بالقوة الحوسبية فقط، بل بالقدرة على اتخاذ قرارات استراتيجية وتنفيذ حركات متسلسلة بدقة متناهية في بيئة ديناميكية.

عند انتهاء التجربة، برز نموذج Claude 3.7 الأحدث من Anthropic كأكثر النماذج تفوقاً، حيث أظهر استجابة سريعة وقدرة على تنفيذ قفزات متقنة أثناء تجنب الأعداء بمهارة. كما قدم نموذج Claude 3.5 أداء جيداً. إلا أن المفاجأة الكبرى كانت في أداء نماذج الذكاء الاصطناعي الأبرز في مجال الاستدلال المنطقي، مثل GPT-4o من OpenAI وGemini 1.5 Pro من Google، حيث عانت هذه النماذج من صعوبة في مجاراة متطلبات اللعبة السريعة.

أشار الباحثون للتوقيت كعامل حاسم في هذا الاختبار، إذ أن جزءاً من الثانية قد يكون الفارق بين النجاح والسقوط في اللعبة. ونظراً لأن النماذج التي تعتمد على التحليل المنطقي العميق تميل إلى التفكير بخطوات متسلسلة، يجعلها هذا بطيئة في الاستجابة للمواقف المتغيرة بسرعة. وهو ما أدى إلى خسارات متكررة في اللعبة.

في حين إن استخدام الألعاب كأداة لقياس قدرات الذكاء الاصطناعي ليس أمراً جديداً، يتساءل بعض الخبراء عن مدى ارتباط هذه الاختبارات بقدرات الذكاء الاصطناعي في العالم الحقيقي. فغالباً ما تكون الألعاب مجرد نماذج مبسطة للواقع، توفر كميات محدودة من بيانات التدريب، على عكس الفوضى والتعقيد في العالم الحقيقي.

بهذا الصدد، حذر الباحث في الذكاء الاصطناعي أندريه كارپاثي من «أزمة تقييم» في المجال، مشيراً إلى أن معايير الاختبار الحالية، وخصوصاً تلك المعتمدة على الألعاب، قد لا تعكس التقدم الحقيقي للذكاء الاصطناعي.

يتجلى هنا تساؤل مشروع وطريف في آن، إذا لم يتمكن الذكاء الاصطناعي من اجتياز مملكة الفطر بمهارة، فهل يمكننا الوثوق به في التعامل مع تعقيدات العالم الحقيقي؟ بطبيعة الحال، تظل تجربة Super Mario وسيلة مثيرة لرصد قدرات الذكاء الاصطناعي من زاوية مختلفة، والاستمتاع بمشاهدة النماذج الذكية وهي تحاول التغلب على التحديات التي تبدو بسيطة للبشر. ولمن يرغب في استكشاف هذا التفاعل المثير، قام مختبر Hao AI بنشر إطار عمل GamingAgent مفتوح المصدر على GitHub.